Como a atenção tornou possível o salto da IA!

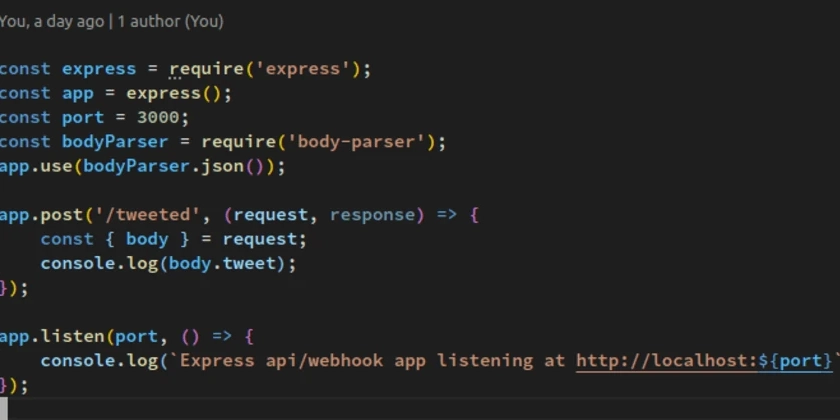

O processamento de linguagem natural, ou PNL, tem sido um campo de estudo significativo há décadas, com pesquisadores e entusiastas aguardando ansiosamente como essa tecnologia transformaria a maneira como nos comunicamos com máquinas. Antes de 2017, a abordagem amplamente usada para tarefas de geração de texto para texto era a rede neural recorrente (RNN) usando uma arquitetura de codificador-decodificador. Nesse padrão, o codificador processaria a palavra de texto de entrada por palavra, e seu estado oculto final seria passado para o decodificador como um “vetor de contexto” comprimido. Este vetor de contexto era um gargalo; Ele teve que codificar todo o significado da frase de entrada, não importa quanto tempo, em um único vetor. Essa era a razão pela qual o modelo costumava “esquecer” as partes anteriores do texto, levando a informações incorretas. Tudo isso mudou quando o Google publicou o artigo “Atenção é tudo o que você precisa” em 2017. Este artigo não apenas introduziu um “mecanismo de atenção” como um complemento; Ele introduziu uma arquitetura revolucionária de rede neural chamada The Transformer (sim, esse foi o começo do LLMS que usamos hoje), que foi construído inteiramente nesse novo conceito. O conceito central do transformador foi o mecanismo de auto-ataque. Esse mecanismo mudou como o modelo processa texto. Em vez de confiar em um único vetor de contexto, o mecanismo de auto-atimento permitiu que o modelo pesasse a importância de diferentes palavras na sequência de entrada ao gerar cada palavra da saída. Essencialmente, para cada palavra que gera, o modelo pode “olhar para trás” em toda a sequência de entrada e decidir quais palavras são mais relevantes para a tarefa em questão. Essa capacidade de se concentrar dinamicamente em diferentes partes da sequência de entrada foi um grande salto para a frente. Ele resolveu o problema do gargalo dos RNNs e os modelos permitiu a lidar com sequências mais longas e mais complexas com precisão. Por que a necessidade disso você pergunta? Bem, para uma, as mesmas palavras podem ter um significado diferente com base na frase em que são usados. Isso cria a necessidade de procurar (como as mesmas palavras podem representar a mesma representação vetorial, esse problema foi resolvido pelo mecanismo de atenção) para os transformadores prever com precisão a próxima palavra na sequência. Para por exemplo, considere o River Bank e o Bank Bankbery, o significado do banco nessas 2 declarações é diferente. Os LLMs que tentam prever o próximo token sem mecanismo de auto-atimento A arquitetura de transformadores, alimentados pelo mecanismo de auto-atimento, lançou as bases para os grandes modelos de idiomas (LLMS) e a IA generativa que temos hoje, como GPT-5, Claude 4.1 e Gemini 2.5 Pro. A capacidade desses modelos de entender o contexto, gerar texto coerente e até executar tarefas complexas de raciocínio é um resultado direto do salto em eficiência e capacidade que o mecanismo de atenção forneceu. Foi realmente o catalisador que tornou possível a atual revolução da IA. Com a invenção da arquitetura do transformador, iniciou a corrida para criar o melhor, mais rápido e pior modelo do mundo. O que, de acordo com você, é o melhor modelo disponível no espaço tecnológico agora. O último que verifiquei que Grok foi o melhor modelo (de acordo com Elon) e ele estava chorando sobre por que não estava listado no principal aplicativo da APA da App Store.

Fonte

Publicar comentário