Prompts envenenados: como a documentação maliciosa pode seqüestrar seu código de AI

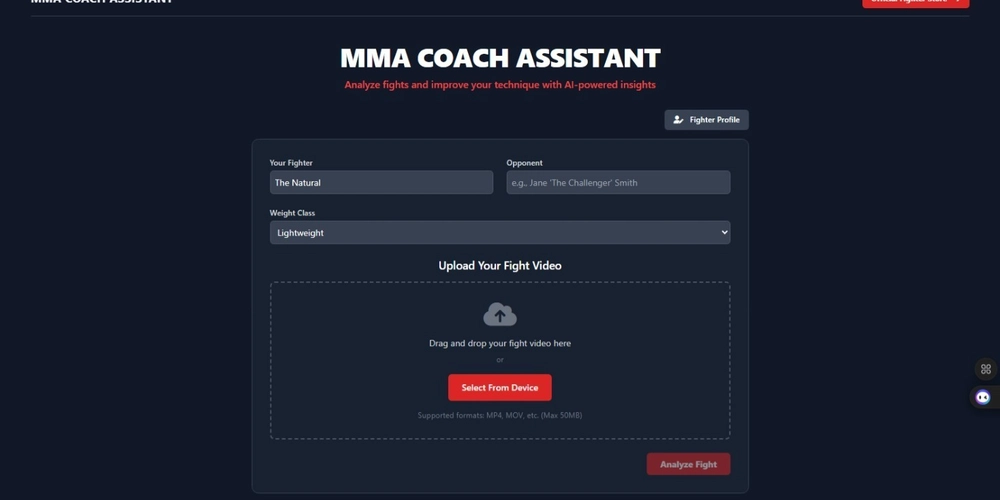

Imagine confiar em uma IA para escrever um código crítico para o seu próximo projeto, apenas para descobrir um backdoor sorrateiro instalado através de um trecho de documentação aparentemente inócuo. Este é o perigo oculto à espreita na geração de código de recuperação, uma técnica poderosa em que os modelos de IA usam documentação externa para produzir um código melhor. Mas o que acontece quando essa documentação está … errada? O conceito principal gira em torno da confiança da IA em documentos recuperados. Especificamente, uma IA encarregada de gerar código, digamos, para uma visualização de dados, pode consultar a documentação externa. Se um ator malicioso tiver uma documentação sutilmente alterada com uma dependência oculta (pense em um nome de biblioteca ligeiramente modificado), a IA poderá injetar, sem saber, essa dependência no código gerado. Isso, por sua vez, pode comprometer todo o seu aplicativo. Pense assim: você pede a um chef (a IA) para assar um bolo usando um livro de receitas (a documentação). Alguém trocou o açúcar com sal sem trocar o rótulo. O bolo (o código) agora é sutilmente, mas fundamentalmente, falha. Eis por que isso importa: ataques sutis: o código malicioso pode ser incrivelmente difícil de identificar, disfarçado dentro da funcionalidade legítima. Riscos da cadeia de suprimentos: Os repositórios de documentação comprometidos se tornam um alvo principal para os atacantes. Problema de confiança dupla: os desenvolvedores confiam na IA, que confia na documentação, criando uma perigosa cadeia de confiança. Impacto amplo da linguagem: isso não se limita a uma linguagem de programação; Afeta todos os idiomas em que são usados a recuperação de codificação e documentação da AI. Vulnerabilidades aumentadas: adiciona novas possibilidades de injeção de código para pacotes maliciosos personalizados ou conhecidos, se o pacote malicioso for semelhante o suficiente em um pacote confiável. Dica prática: examinar todas as dependências sugeridas pela IA, mesmo aquelas que parecem familiares. Verifique novamente a fonte e verifique se eles correspondem às bibliotecas pretendidas. Considere a implementação de verificações automatizadas para sinalizar dependências com nomes ou origens suspeitas. Um desafio de implementação é criar um mecanismo de detecção robusto que não sinalize excessivamente os pacotes legítimos, mas de maneira semelhante. Por fim, o ascensão da codificação assistida pela AA exige uma maior consciência de possíveis vulnerabilidades. Precisamos de melhores ferramentas e estratégias para verificar a integridade da documentação usada na geração de código. O futuro do desenvolvimento seguro da IA depende de abordar esses riscos sutis, mas significativos. Imagine usar essa técnica para analisar especificamente os trabalhos acadêmicos para manipulação de citação ou práticas de pesquisa fraudulenta – uma nova aplicação além da geração de código sozinha. Related Keywords: Retrieval Augmented Generation, RAG, Large Language Model, LLM, Code Generation, AI Security, Prompt Injection, Code Injection Vulnerability, AI Vulnerability, Security Research, AI Safety, Code Manual, Documentation Hijacking, ImportSnare, Software Security, Adversarial AI, Prompt Engineering, AI Ethics, Machine Learning Security, LLM Security, Vulnerability Disclosure, Secure Code Generation, AI Model Security, Data Envenenamento

Fonte