AI multimodal: além da inteligência de modo único

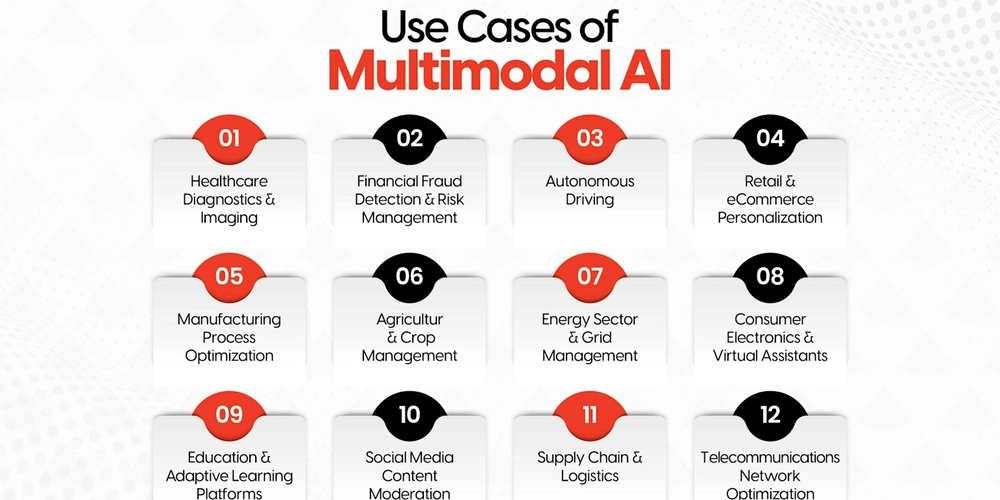

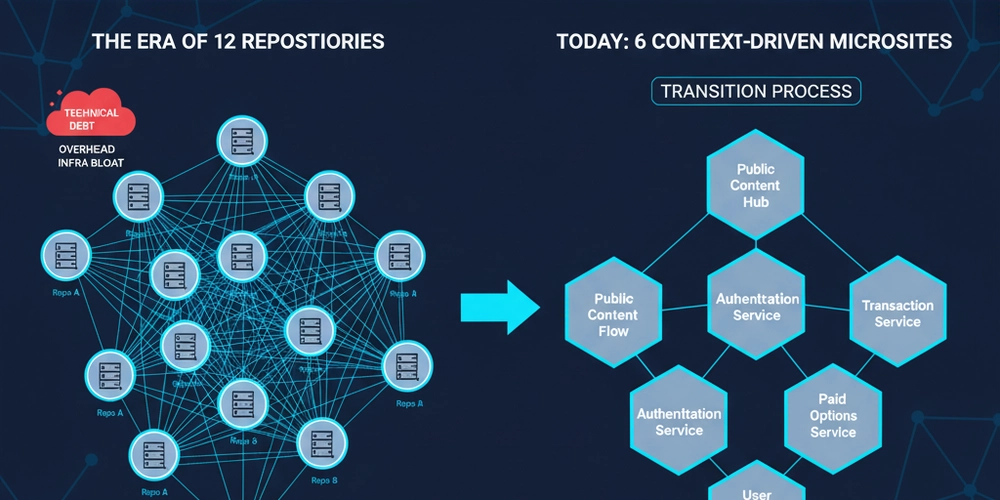

A convergência do processamento de texto, imagem, áudio e vídeo em sistemas de IA unificados está transformando fundamentalmente como as máquinas entendem e interagem com o mundo. A IA multimodal representa o próximo salto evolutivo de modelos especializados de domínio único para plataformas de inteligência abrangentes que refletem processos cognitivos humanos. O mercado multimodal de IA experimentou um crescimento explosivo, excedendo \ US $ 1,6 bilhão em 2024 e projetado para expandir a uma taxa de crescimento anual composta de 32,7% a 2034. Essa transformação marca uma mudança crucial de sistemas de IA tradicionais que se destacam em domínios estreitos para plataformas sofisticadas, capacitadas de processamento e compreensão de múltiplos tipos de múltiplos tipos de dados simultâneos. Casos de uso de assistência médica multimodal de IA Span, direção autônoma, assistentes inteligentes e muito mais em vários setores. A base dos sistemas tradicionais de IA de inteligência multimodal operavam dentro de domínios isolados – modelos de linguagem entendiam texto, imagens processadas por visão computacional e áudio tratado com reconhecimento de fala. A IA multimodal quebra essas barreiras, integrando várias modalidades de entrada para obter recursos abrangentes de entendimento e análise. Esses sistemas processam texto, imagens, áudio e vídeo simultaneamente, criando uma consciência contextual mais rica que reflete de perto a percepção humana. A vantagem principal está no aprendizado cruzado, onde o conhecimento de um domínio aprimora a compreensão em outro. Por exemplo, um sistema multimodal pode analisar os sintomas falados de um paciente (áudio), registros médicos (texto) e imagens de diagnóstico (visual) para fornecer diagnósticos mais precisos do que qualquer sistema de modo único poderia alcançar independentemente. Diagrama mostrando o fluxo de trabalho do reconhecimento de fala, desde a captura de som até os estágios pós-processamento. Evolução arquitetônica: Os transformadores multimodais da revolução do transformador representam o avanço tecnológico que permite essa convergência. Diferentemente das arquiteturas anteriores que exigiram pipelines de processamento separados para diferentes tipos de dados, os modelos de transformadores usam mecanismos de auto-distribuição que tratam todas as entradas como sequências de tokens, independentemente da modalidade. A natureza da modalidade-agnóstica da arquitetura do transformador permite processar diversos tipos de dados dentro de uma estrutura unificada. O texto é tokenizado em palavras, as imagens são divididas em patches e o áudio é segmentado em características temporais – todas convertidas em incorporações que o transformador pode processar simultaneamente através de seus mecanismos de atenção. Arquitetura de transformador multimodal proposta que integra a codificação de imagens médicas e a decodificação de texto com o aprimoramento de atendimento cruzado e conhecimento externo. As camadas de participação cruzada permitem que esses modelos estabeleçam relacionamentos entre diferentes modalidades. Por exemplo, ao processar um vídeo com comentários de áudio, o sistema pode conectar palavras faladas aos elementos visuais correspondentes, criando um entendimento abrangente que excede a soma de suas partes. Sistemas de IA multimodais líderes O cenário competitivo apresenta três plataformas dominantes, cada uma com forças distintas: o GPT-4O (OpenAI) leva no processamento multimodal em tempo real, alcançando aproximadamente tempos de resposta de 300 ms para interações de voz. Sua integração nativa de processamento de texto, imagem e áudio o torna particularmente eficaz para aplicativos voltados para o cliente. O Gemini 1.5 Pro (Google) se destaca com sua enorme janela de contexto e recursos multimodais internos desde o início. O sistema pode processar sequências estendidas em várias modalidades, mantendo a coerência, tornando -o valioso para tarefas analíticas complexas. Claude 3 Opus (Antrópico) se concentra na confiabilidade e segurança, embora atualmente enfatize o processamento de texto e imagem em relação aos recursos de áudio. Sua abordagem constitucional de IA garante resultados consistentes e confiáveis entre as modalidades. Os benchmarks de desempenho demonstram a superioridade do GPT-4O na maioria das métricas de avaliação, incluindo 69,1% de precisão em tarefas de correspondência multimodal e 94,2% nas avaliações de compreensão do diagrama. As aplicações revolucionárias em toda a IA de transformação de saúde da indústria está revolucionando o diagnóstico médico, integrando registros eletrônicos de saúde, imagem médica e notas clínicas. A IBM Watson Health exemplifica essa integração, combinando fontes de dados díspares para melhorar a precisão do diagnóstico e criar planos de tratamento personalizados. O sistema pode analisar simultaneamente as tomografias, histórias de pacientes e dados de sensores de dispositivos vestíveis para fornecer avaliações abrangentes de saúde. Os aplicativos automotivos de inteligência de veículos autônomos aproveitam a IA multimodal para aprimorar os recursos de segurança e navegação. Esses sistemas integram dados de sensores de câmeras, radar, lidar e GPS para criar um entendimento ambiental abrangente. O inovador manual do proprietário digital da Toyota demonstra como a IA multimodal pode transformar a documentação tradicional combinando texto, imagens e informações contextuais em experiências interativas. As instituições financeiras de segurança e gerenciamento de riscos financeiras implantam IA multimodal para sofisticada detecção de fraudes e avaliação de riscos. O DOCLLM do JP Morgan combina dados textuais, metadados e informações contextuais de documentos financeiros para melhorar a precisão da análise de documentos e automatizar os processos de conformidade. Esses sistemas analisam padrões de transação, comportamento do usuário e dados históricos para identificar anomalias de maneira mais eficaz do que os sistemas de modo único. As plataformas aprimoradas da experiência do cliente e o comércio eletrônico utilizam IA multimodal para criar experiências de compras personalizadas. O Stylesnap da Amazon usa visão computacional e processamento de linguagem natural para recomendar itens de moda com base em imagens carregadas. O sistema combina análise visual com descrições textuais e preferências do usuário para fornecer recomendações precisas do produto. Aplicações da IA generativa multimodal nos setores de saúde, automotivo, comércio eletrônico, entretenimento e mídia social. A arquitetura técnica e a integração de dados de implementação desafiam a implementação da IA multimodal apresenta desafios técnicos significativos. O alinhamento e a sincronização de dados requerem coordenação precisa entre modalidades com diferentes características temporais, espaciais e semânticas. A sincronização audiovisual, por exemplo, exige precisão no nível do quadro para manter a coerência. As demandas computacionais excedem significativamente as dos sistemas de modo único. Grandes modelos multimodais geralmente contêm bilhões de parâmetros e requerem poder substancial de processamento para treinamento e inferência. As restrições de memória se tornam fatores críticos ao implantar esses sistemas em ambientes de produção. Estratégias de fusão Os sistemas multimodais modernos empregam mecanismos sofisticados de fusão: a fusão precoce combina todas as modalidades antes do processamento do modelo, enquanto a fusão tardia processa cada modalidade separadamente antes de combinar saídas. A fusão intermediária projeta modalidades em espaços latentes compartilhados para integração, e a fusão híbrida combina várias estratégias em diferentes fases de processamento. Limitações atuais e desafios futuros, apesar do progresso notável, a IA multimodal enfrenta limitações substanciais. A interpretabilidade continua sendo um desafio crítico, pois a complexidade da integração de múltiplas modalidades dificulta o entendimento dos processos de tomada de decisão. Essa opacidade representa preocupações particulares nas aplicações que exigem responsabilidade, como diagnóstico médico ou tomada de decisão legal. A qualidade dos dados e o viés apresentam desafios contínuos. Os sistemas multimodais podem herdar vieses de dados de treinamento em todas as modalidades, potencialmente ampliando os resultados discriminatórios. Garantir dados de treinamento diversos e representativos, mantendo os padrões de qualidade, requer recursos substanciais e curadoria cuidadosa. Os custos computacionais permanecem proibitivos para muitas aplicações. Os requisitos de recursos para treinamento e implantação de grandes modelos multimodais geralmente requerem acesso a clusters de GPU de alto desempenho, limitando a acessibilidade para organizações menores. O caminho a seguir: tendências emergentes e instruções futuras Agentic IA Desenvolvimento emergente Os sistemas Agentic AI combinam raciocínio multimodal com recursos autônomos de tomada de decisão. Esses sistemas podem analisar feeds de vídeo, processar instruções faladas e interpretar instruções por escrito para alcançar objetivos complexos de forma independente. Até 2027, o Gartner prevê que 40% das soluções generativas de IA serão multimodais, acima de apenas 1% em 2023. Sistemas avançados de comutação de contexto em tempo real estão desenvolvendo recursos de comutação de contexto em tempo real, permitindo transições perfeitas entre reconhecimento de comandos de voz, análise de imagens e respostas baseadas em texto. Essa flexibilidade é crucial para assistentes inteligentes e aplicativos de robótica, onde o contexto pode mudar rapidamente. A implantação e eficiência de borda modelos multimodais projetados para ambientes móveis e de borda estão emergindo como desenvolvimentos críticos. Esses sistemas otimizados trazem recursos de IA diretamente para dispositivos, reduzindo a dependência da conectividade em nuvem e permitindo aplicativos em ambientes aumentados de realidade e internet das coisas.

Fonte