As pessoas ficam furiosas que o OpenAI está relatando conversas de chatgpt à aplicação da lei

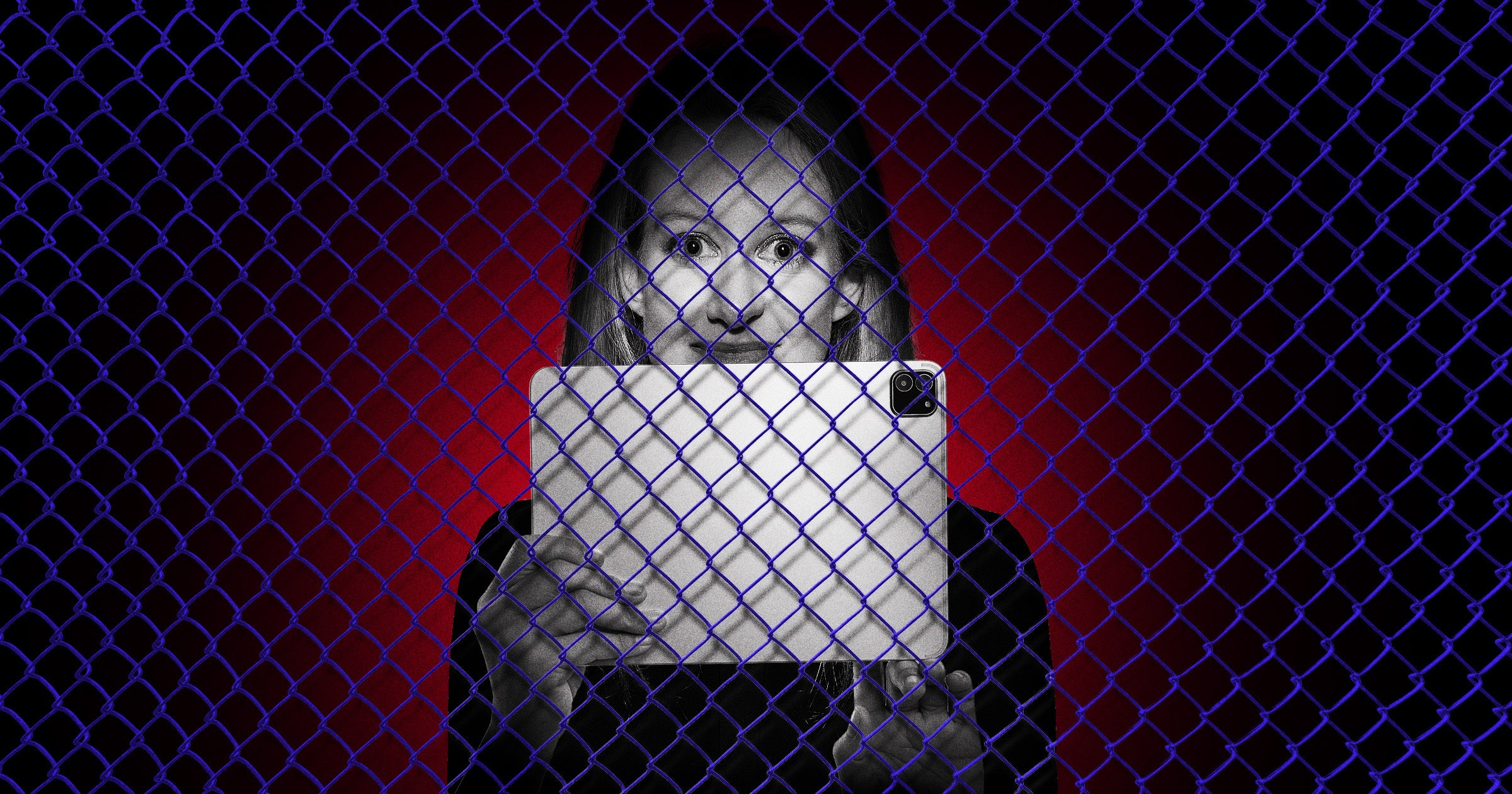

Earlier this week, buried in the middle of a lengthy blog post addressing ChatGPT’s propensity for severe mental health harms, OpenAI admitted that it’s scanning users’ conversations and reporting to police any interactions that a human reviewer deems sufficiently threatening.”When we detect users who are planning to harm others, we route their conversations to specialized pipelines where they are reviewed by a small team trained on our usage policies and who are authorized to take action, incluindo a proibição de contas “, escreveu. “Se os revisores humanos determinam que um caso envolve uma ameaça iminente de danos físicos graves a outras pessoas, podemos encaminhá -lo à aplicação da lei”. O anúncio levantou questões imediatas. Os moderadores humanos não julgam o tom, por exemplo, minuam toda a premissa de um sistema de IA que seus criadores dizem que podem resolver problemas amplos e complexos? Como o OpenAI está descobrindo os locais precisos dos usuários para fornecê -los a equipes de emergência? Como ele está protegendo contra o abuso pelos chamados swatters, quem poderia fingir ser outra pessoa e depois fazer ameaças violentas para o Chatgpt para obter suas metas invadidas pela polícia? Plenty of folks online, though, are responding forcefully to the news.”The surveillance, theft and death machine recommends more surveillance to balance out the death,” quipped Harvard Law School labor researcher Michelle Martin.Many readers responded with a basic reality: injecting heavily-armed police — unlikely to be trained in effective de-escalation tactics — into a tense situation involving a mental health crisis often results in an even worse resultado. (Isso não é uma preocupação teórica; no início deste ano, um homem foi morto por policiais quando ele entrou em psicose da IA.) “Ah, sim, envolve a polícia”, escreveu John Darnielle, um romancista, músico e pensador público premiado. “Isso certamente ajudará.” Outros apontaram que, embora o OpenAI atualmente diga que está apenas notificando as autoridades quando um indivíduo expressa a intenção de ferir outras pessoas-e exclui as pessoas que expressam um desejo de se machucar-há um imenso precedente na indústria de tecnologia que não foi a gentileza que a Snowden não foi a que se afastava que a pressão corporativa e do governo. Principais empresas de tecnologia como Microsoft, Google, Apple, etc. “, escreveu o desenvolvedor e blogueiro da IA Charles McGuinness. “Não é paranóico pensar que o ChatGPT está encaminhando o conteúdo” interessante “para o governo dos EUA agora.” A admissão também parece contradizer comentários do CEO da Openai, Sam Altman, que recentemente pediu privacidade semelhante a um “terapeuta ou um advogado”, incluindo um dos médicos que os usuários de que os usuários estão falando para que os usuários do que os usuários de que os usuários do que os usuários estão de pé. “Se houver um risco que o AIS possa começar a relatar consultas à aplicação da lei, a falta de confidencialidade pode ser um problema para os advogados, especialmente os advogados de defesa criminal que costumam escrever sobre crimes”. Em certo sentido, alguns reconhecidos, o Openai é pego entre uma rocha e um lugar difícil. A ótica de sua IA puxando os usuários para espirais de psicose, auto-prejudicar e pior são assustadores-e, aparentemente incapaz de controlar sua tecnologia, a implementação da moderação humana pesada é a solução odiosa. “Não sei, quando você começa a culpar o Openi porque as pessoas doenças fizeram pessoas doentes, arquivar processos maciços e atormentar [a] A campanha da imprensa, parece que a correção do curso totalmente previsível “, escreveu Ari Cohn, o principal advogado da política tecnológica da Fundação para Direitos e Expressões Individuais, um grupo de liberdade de expressão.” Você queria que os corrimãos sejam de doenças mentais, que não podem encontrar a indústria prejudicial, agora que você entendeu “, mas em um nível mais amplo, argumentou que outras pessoas se tornam que a indústria de IA é que a indústria de AI não se aprende com pouco” haphazard solutions to real-world problems as they arise.”It’s great that when we find out a product can harm people, we don’t remove the product from shelves or try to improve it, we instead call the police,” another user griped. “Totally not a carceral state y’all.”And at the end of the day, a familiar pattern is playing out for longtime adopters of new technology: the growing sense that, even in your most intimate moments, you are being Assisti. “Stalin teria se acenado”, escreveu a estudiosa de história russa Katherine Pickering Antonova, professora do Queens College.

Fonte