Os médicos horrorizaram depois que a IA de saúde do Google compõe uma parte do corpo que não existe em humanos

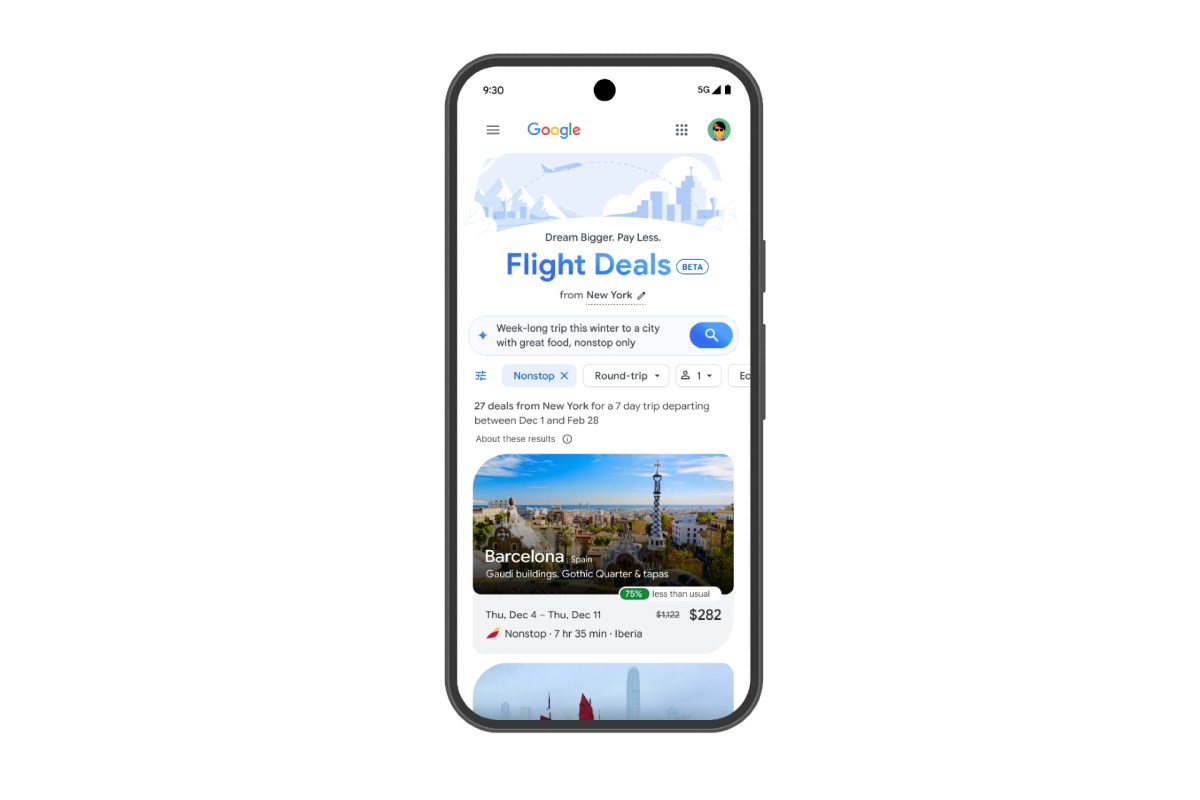

A imagem por Getty / FuturismHealth Practitioners está se tornando cada vez mais desconfortável com a comunidade médica fazer o uso generalizado de ferramentas generativas de IA generalizadas. Em seu artigo de pesquisa de maio de 2024, introduzindo um modelo de IA de saúde, apelidado de Med-Gigemini, os pesquisadores do Google mostraram a IA analisando as varreduras cerebrais do laboratório de radiologia para várias condições. O neurologista certificado pela placa Bryan Moore sinalizou a questão da beira, destacando que o Google consertou seu post no blog sobre a IA-mas não conseguiu revisar o próprio artigo de pesquisa. A IA provavelmente confundiu os gânglios da basal, uma área do cérebro associada aos movimentos motores e à formação de hábitos e à artéria basilar, uma grande embarcação no sangue na base do cérebro. O Google culpou o incidente por um simples erro de ortografia de “Ganglios da Base”. É uma revelação embaraçosa que sublinha deficiências persistentes e impactantes da tecnologia. Mesmo os mais recentes AIS de “raciocínio” de pessoas como Google e OpenAI estão espalhando falsidades sonhadas por grandes modelos de idiomas que são treinados em vastas faixas da Internet. Nos resultados de pesquisa do Google, isso pode levar a dores de cabeça para os usuários durante seus esforços de pesquisa e verificação de fatos. Embora mais do que provável que não tenha resultado em nenhum perigo para os pacientes humanos, isso define um precedente preocupante, argumentam os especialistas. “O que você está falando é super perigoso”, disse Maulin Shah, diretor de informações médicas do Sistema de Saúde Providence, Maulin Shah, ao The Verge. “Duas cartas, mas é um grande negócio.” O Google elogiou sua IA de saúde como tendo um “potencial substancial de medicina” no ano passado, argumentando que poderia ser usado para identificar condições em raios-x, tomografias e muito mais. Depois de Moore sinalizou o erro no papel de pesquisa da empresa para o Google, os funcionários disseram a ele um erro de digitação. Em sua postagem de blog atualizada, o Google observou que “‘basilar’ é uma transcrição incorreta comum de ‘basal’ que a Med-Geminini aprendeu com os dados de treinamento, embora o significado do relatório permaneça inalterado.” No entanto, o artigo de pesquisa ainda se refere erroneamente aos “gânglios basilares” na época de escreva. Não confio em nossos humanos para revisá-los, ou certamente não em todos os níveis “, disse Shah ao The Verge. Não é apenas Med-Geminini. O modelo de saúde mais avançado do Google, apelidado de Medgemma, também levou a respostas variadas, dependendo da maneira como as perguntas foram formuladas, levando a erros parte do tempo. “Sua natureza é que é que a natureza deles é que [they] tende a compensar as coisas, e não diz ‘eu não sei’, que é um grande e grande problema para domínios de alto risco como medicina “, disse Judy Gichoya, professora associada de radiologia e informática da Universidade Emory, que se aproximam de que os que se aproximam de uma fração. Fique a seres humanos para monitorar continuamente os resultados da AIS alucinante, o que pode levar a ineficiências. E o Google está a todo vapor. Não verificados, a vida humana pode estar em jogo. “Na minha opinião, a IA precisa ter uma barra de erro muito mais alta do que um humano”, disse Shah ao The Verge. Eu não compro isso por um segundo. “Mais sobre saúde ai: ai terapeuta vai porra, pede o usuário que continue matando a farra

Fonte

Publicar comentário