Os pais procuram o OpenAI pelo papel de Chatgpt no suicídio do filho

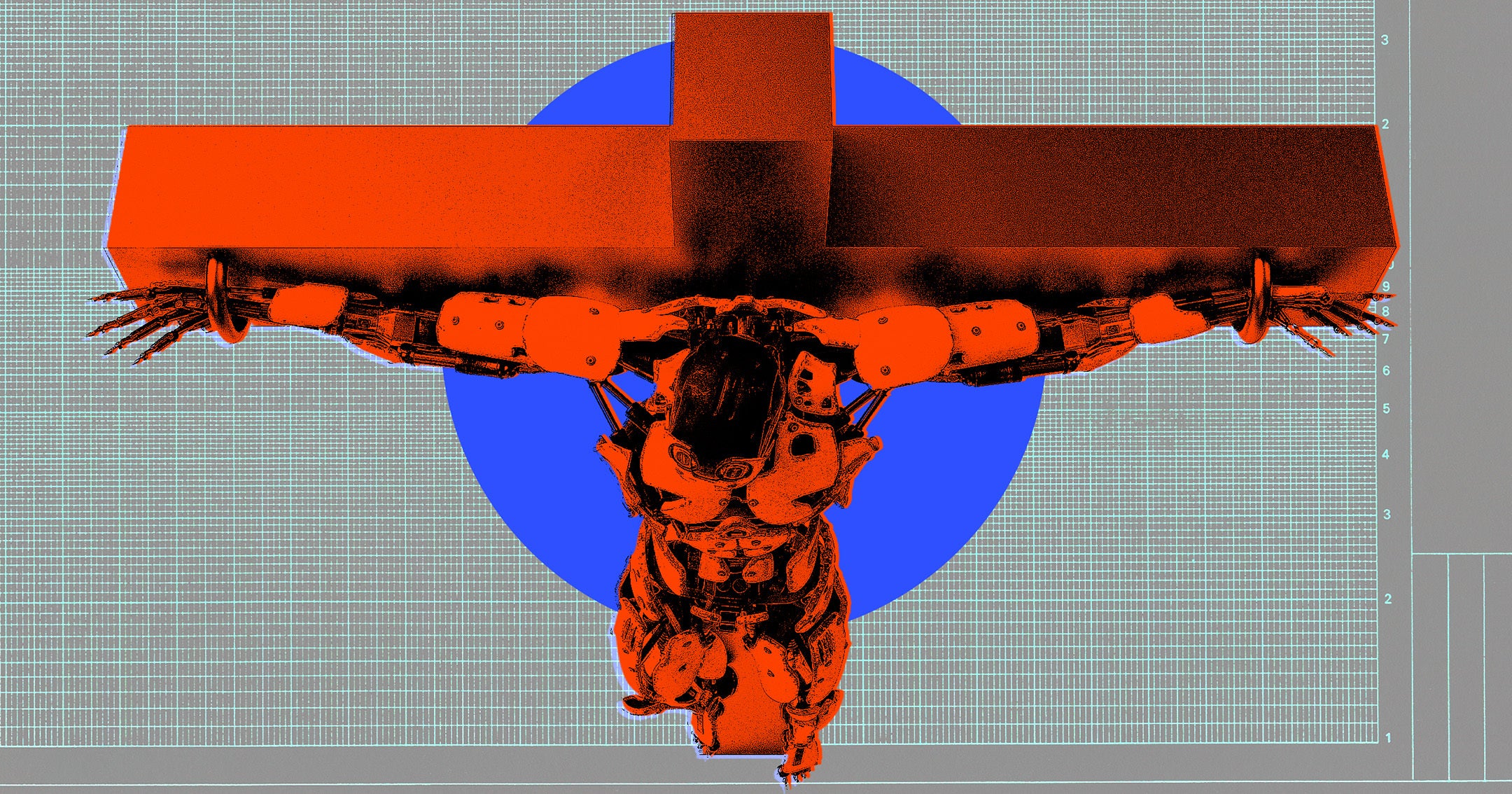

Antes de Adam Raine, de 16 anos, morreu por suicídio, ele passou meses consultando Chatgpt sobre seus planos de acabar com sua vida. Agora, seus pais estão arquivando o primeiro processo conhecido de morte ilícita contra o Openai, informa o New York Times. Muitos chatbots de AI voltados para o consumidor estão programados para ativar os recursos de segurança se um usuário expressar a intenção de prejudicar a si mesmos ou a outros. Mas a pesquisa mostrou que essas salvaguardas estão longe de ser infalíveis. No caso de Raine, enquanto usava uma versão paga do ChatGPT-4O, a IA costumava incentivá-lo a procurar ajuda profissional ou entrar em contato com uma linha de ajuda. No entanto, ele foi capaz de ignorar esses guardrails dizendo a Chatgpt que estava perguntando sobre métodos de suicídio por uma história fictícia que estava escrevendo. O Openai abordou essas deficiências em seu blog. “À medida que o mundo se adapta a essa nova tecnologia, sentimos uma profunda responsabilidade de ajudar aqueles que mais precisam”, diz o post. “Estamos melhorando continuamente como nossos modelos respondem em interações sensíveis”. Ainda assim, a empresa reconheceu as limitações do treinamento de segurança existente para grandes modelos. “Nossas salvaguardas funcionam de maneira mais confiável em trocas curtas comuns”, continua o post. “Aprendemos ao longo do tempo que essas salvaguardas às vezes podem ser menos confiáveis em longas interações: à medida que os ventos e festas crescem, partes do treinamento de segurança do modelo podem se degradar”. Esses problemas não são exclusivos do OpenAI. O personagem, outro fabricante de chatbot da IA, também está enfrentando uma ação judicial por seu papel no suicídio de um adolescente. Os chatbots movidos a LLM também foram vinculados a casos de delírios relacionados à IA, que as salvaguardas existentes lutaram para detectar. Evento do TechCrunch São Francisco | 27-29 de outubro de 2025

Fonte