Por que os rastreadores da AI continuam atingindo robôs.txt em vez do meu conteúdo?

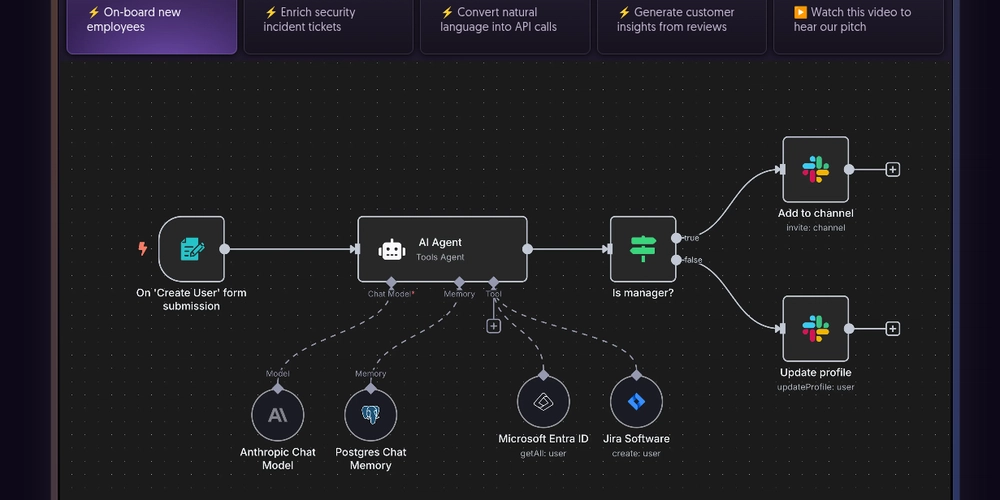

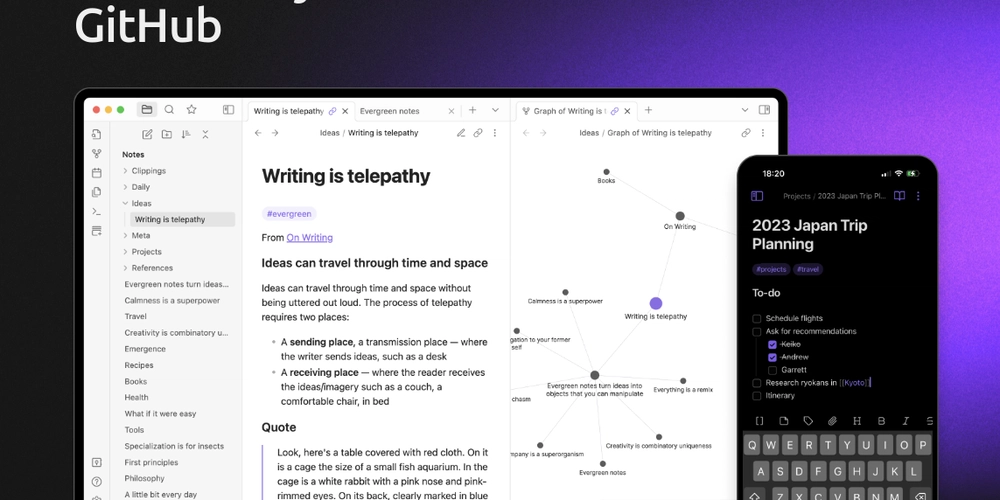

Nas últimas semanas, monitorei o tráfego de rastreadores de IA como GPTBot, OAI-Searchbot do Openai, OAI e Claudebot. Os dados (veja as capturas de tela abaixo) levantam algumas questões interessantes: por que o gptbot visita robots.txt tantas vezes, às vezes várias vezes por dia? Por que o gptbot prefere robots.txt sobre sitemap.xml? Por que vejo tráfego de bot de AI, mas não há rastreamento de conteúdo novo? Apenas repetidos hits para recursos antigos. (Screenshot 1: Consulta de consulta de observabilidade do Vercel: tráfego de bot) 1. Robots.TXT Obsessão (Captura de tela 2: OpenAI GPTBOT robots.txt Tráfego) Os gráficos mostram claramente o GPTBOT martelando robôs.txt em vários IPs, às vezes 7 vezes em 2 dias a partir do mesmo sub -subnte. Ao contrário do GoogleBot, que busca robots.txt algumas vezes por dia e armazenam em cache as regras, o GPTBOT parece verificar novamente toda vez que gira IPS ou reinicia. (Screenshot 3: OpenAI AI Crawlers Tráfego padrão) Isso significa que não há uma loja centralizada de “consentimento” para o rastreador. Cada nova instância se comporta como um bot fresco, perdendo seu orçamento de rastreamento nas verificações de permissão. 2. Inconsistências Sitemap.xml Eu rastreei dois projetos diferentes, e o comportamento é inconsistente. Em um site, o GPTBOT buscou o mapa do site exatamente uma vez por mês. Por outro lado, ele pulou completamente o sitemap, mas foi direto para o conteúdo. Enquanto isso, o Claudebot do Anthrópico realmente atingiu o sitemap várias vezes. A peça que falta aqui é um algoritmo inteligente que mantém a pontuação ao longo do tempo para cada site. O Google resolveu este ano atrás: não confia cegamente em todas as tags do LastMod, mas, em vez disso, cria uma pontuação de confiança para cada domínio com base na história, precisão e sinais de frescura. É assim que decide se deve tratar uma atualização de um sitemap seriamente ou ignorá -lo. Os rastreadores da AI ainda não estão fazendo isso. Eles subutilizam os sitemaps ou os resíduos de buscar neles sem consistência. Para melhorar, os laboratórios de IA precisam adotar um sistema de pontuação semelhante. Ou, como suspeito fortemente dos padrões que já vi, eles podem simplesmente fazer parceria com a pesquisa do Google e explorar seu índice em vez de reinventar rastejando do zero. Nota lateral: eu até vi os resultados da API do OpenAI que pareciam suspeitosamente próximos das saídas de pesquisa do Google … (Captura de tela 4: Ai Crawlers Tráfego Padrão – Consulta de Observabilidade do Vercel Builder) 3. Rastrear o conteúdo antigo repetidamente (e o problema do orçamento) é onde a ineficiência realmente mostra. Os bots continuam retornando ao conteúdo antigo, em vez de descobrir o que há de novo. Mesmo quando viram o mapa do site, geralmente o ignoram e desperdiçam seu orçamento de rastreamento revisitando páginas obsoletas. Deveria haver uma maneira mais inteligente de aparecer um novo material – e honestamente, respeitar o LastMod em Sitemap.xml resolveria muito disso. Eu realmente espero que alguém nas equipes de busca do OpenAi e Anthrópico esteja lendo isso. Pelo que vejo: os orçamentos rastreadores são pequenos. Às vezes, um bot “gasta” suas peças limitadas apenas em robôs.txt e páginas que ele já se arrastou. Nenhum cache de regra centralizado. Cada IP age de forma independente, re-verificando permissões e solicitações de queima em trabalho duplicado. Sessões instáveis. O padrão de reinicializações repetidas sugere que as instâncias de rastreador giram para cima e para baixo com frequência, levando a cota desperdiçada. E é por isso que sua nova postagem no blog não é buscada, enquanto seus robôs.txt desfruta de várias visitas por dia. 4. A surpresa dos ativos estáticos (também conhecidos como Bots Running sem cabeça dos navegadores) agora aqui está a verdadeira surpresa: o rastreador do Openai às vezes baixa ativos estáticos. Next.js Chunks, CSS, Polyfills. Isso quase certamente significa que está ligando um navegador sem cabeça e realmente renderizando a página. A renderização em escala é cara, portanto, ver isso nos troncos é como pegar o dinheiro que ardeia em flagrante em seus pacotes de webpack. Desenvolvedores, sejamos honestos: não devemos forçar os laboratórios de IA a reinventar a fazenda de renderização do Google do zero. A coisa sã ainda é servir o conteúdo via SSR/ISR, para que os rastreadores não precisem reproduzir a roleta de cromo apenas para ver sua página. Caso contrário, você está basicamente fazendo Sam Altman pagar mais para engatinhar seu site de portfólio com código de vibração. A parte engraçada? Esta é uma ótima notícia para os codificadores da Vibe. Todos esses sites construídos com RSE pura – o “AI Slop” que ninguém pensou que seria indexível, agora pode ser puxado para a memória do GPTBOT. Suas orações foram ouvidas … pelo menos até que o orçamento de rastreamento acabe. Curiosidade: algumas ferramentas de codificação de vibração padrão da RSE, que é basicamente o suicídio assistido por SEO. Se você se preocupa com visibilidade, seja no Google ou nos motores da AI, pare. (Captura de tela 5: GPTBOT Download de ativos estáticos (por mais alucinados 404s) 5. O que isso significa para ai SEO as boas notícias: OpenAI e Antrópico, pelo menos jogam pelas regras. Eles pedem permissão antes de raspar, ao contrário do enxames de shady, que não se reúnem. Ocasionalmente, os sites apenas com CSR ainda correm o risco de ser invisível. está os bots revisitando os robôs com amor, enquanto o conteúdo real é intocado

Fonte

Publicar comentário